Dans les coulisses : Notre laboratoire de ML

Ce qu'il y a à l'intérieur

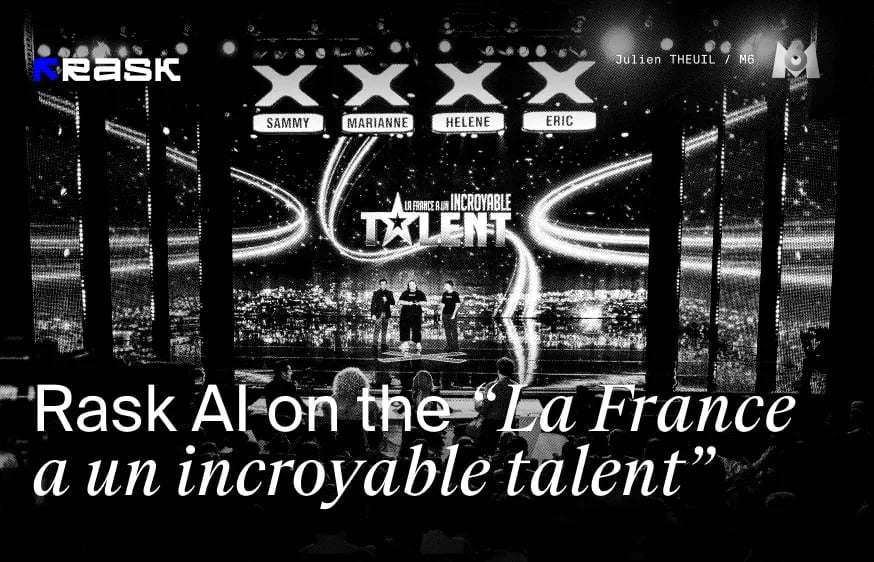

Dans notre dernier article, nous plongeons dans le monde passionnant de la technologie de synchronisation labiale deRask AI, avec les conseils de Dima Vypirailenko, responsable de l'apprentissage automatique au sein de l'entreprise. Nous vous emmenons dans les coulisses du Brask ML Lab, un centre d'excellence pour la technologie, où nous voyons de première main comment cet outil d'IA innovant fait des vagues dans la création et la distribution de contenu. Notre équipe est composée d'ingénieurs ML et d'artistes synthétiques VFX de classe mondiale qui ne se contentent pas de s'adapter à l'avenir, mais le créent.

Rejoignez-nous pour découvrir comment cette technologie transforme l'industrie de la création, réduit les coûts et aide les créateurs à atteindre des publics dans le monde entier.

Qu'est-ce que la technologie de synchronisation labiale ?

L'un des principaux défis de la localisation vidéo est le mouvement non naturel des lèvres. La technologie de synchronisation des lèvres est conçue pour aider à synchroniser efficacement les mouvements des lèvres avec les pistes audio multilingues.

Comme nous l'avons appris dans notre dernier article, la technique de synchronisation labiale est beaucoup plus complexe que la simple synchronisation - il faut aussi que les mouvements de la bouche soient corrects. Tous les mots prononcés auront un effet sur le visage de l'orateur, comme le "O" créera évidemment une forme ovale de la bouche et ne sera donc pas un "M", ce qui rendra le processus de doublage encore plus complexe.

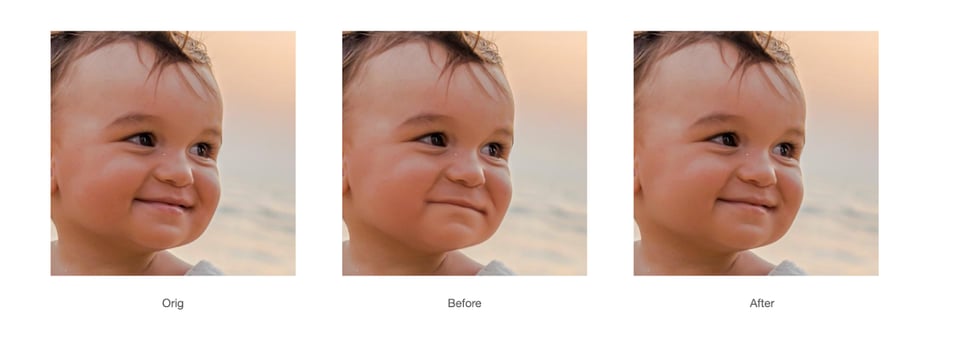

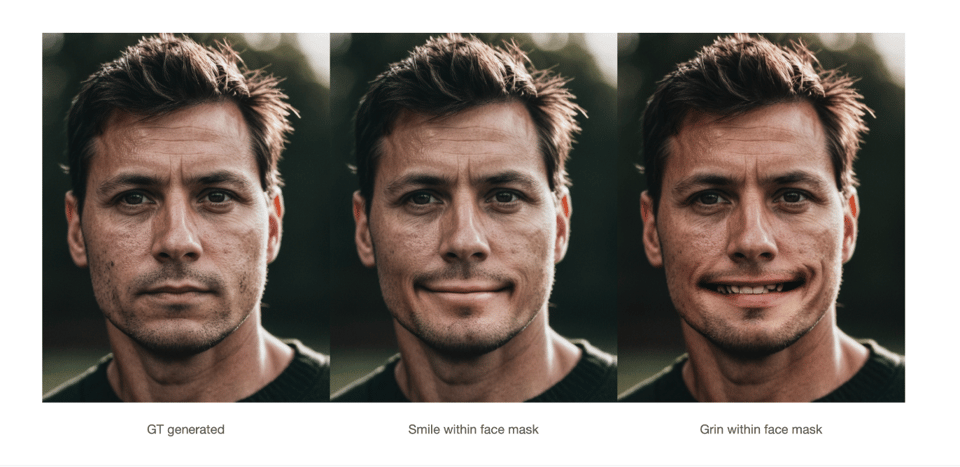

Voici le nouveau modèle de synchronisation labiale avec une meilleure qualité !

Notre équipe ML a décidé d'améliorer le modèle de synchronisation labiale existant. Qu'est-ce qui a motivé cette décision et quelles sont les nouveautés de cette version par rapport à la version bêta ?

Des efforts considérables ont été déployés pour améliorer le modèle, notamment :

- Précision améliorée : Nous avons affiné les algorithmes d'IA pour mieux analyser et faire correspondre les détails phonétiques de la langue parlée, ce qui permet d'obtenir des mouvements des lèvres plus précis et étroitement synchronisés avec le son dans plusieurs langues.

- EnhancedNaturalness : En intégrant des données de capture de mouvement plus avancées et en affinant nos techniques d'apprentissage automatique, nous avons considérablement amélioré le naturel des mouvements des lèvres, ce qui donne à la parole des personnages un aspect plus fluide et plus réaliste.

- Augmentation de lavitesse et de l'efficacité : Nous avons optimisé le modèle pour traiter les vidéos plus rapidement sans sacrifier la qualité, ce qui permet d'accélérer les délais d'exécution des projets nécessitant une localisation à grande échelle.

- Intégration des commentaires des utilisateurs : Nous avons activement recueilli les commentaires des utilisateurs de la version bêta et intégré leurs idées dans le processus de développement afin de résoudre des problèmes spécifiques et d'améliorer la satisfaction générale des utilisateurs.

Comment notre modèle d'IA synchronise-t-il les mouvements des lèvres avec la traduction audio ?

Dima : "Notre modèle d'intelligence artificielle combine les informations de la traduction audio avec les informations sur le visage de la personne dans le cadre, puis les fusionne dans le résultat final. Cette intégration garantit que les mouvements des lèvres sont synchronisés avec précision avec le discours traduit, offrant ainsi une expérience visuelle transparente".

Quelles sont les caractéristiques uniques qui font de Premium Lip-Sync la solution idéale pour les contenus de haute qualité ?

Dima : "Premium Lip-sync est spécialement conçu pour traiter des contenus de haute qualité grâce à ses caractéristiques uniques, telles que la capacité multi-haut-parleurs et la prise en charge de la haute résolution. Elle peut traiter des vidéos d'une résolution allant jusqu'à 2K, ce qui garantit le maintien de la qualité visuelle sans compromis. En outre, la fonction multilocuteurs permet une synchronisation labiale précise entre les différents locuteurs d'une même vidéo, ce qui la rend très efficace pour les productions complexes impliquant plusieurs personnages ou locuteurs. Ces caractéristiques font de Premium Lipsync un choix de premier ordre pour les créateurs qui souhaitent un contenu de qualité professionnelle".

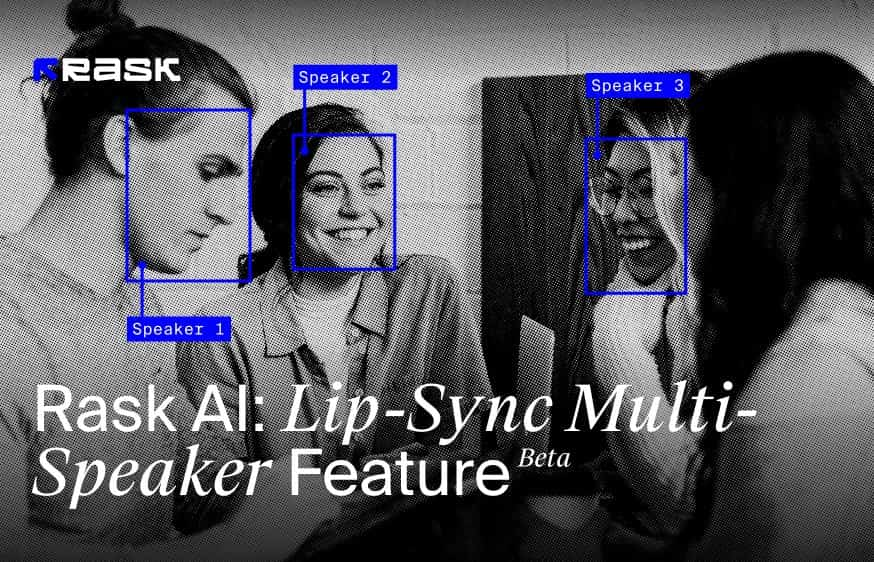

Qu'est-ce qu'une fonction de synchronisation labiale multi-interlocuteurs ?

La fonction de synchronisation labiale multilocuteurs est conçue pour synchroniser avec précision les mouvements des lèvres avec l'audio parlé dans les vidéos mettant en scène plusieurs personnes. Cette technologie avancée identifie et différencie plusieurs visages dans une même image, garantissant que les mouvements des lèvres de chaque personne sont correctement animés en fonction des paroles prononcées.

Fonctionnement de la synchronisation labiale à plusieurs haut-parleurs :

- Reconnaissance des visages dans le cadre : Cette fonction reconnaît initialement tous les visages présents dans l'image vidéo, quel que soit leur nombre. Elle est capable d'identifier chaque individu, ce qui est essentiel pour une synchronisation labiale précise.

- AudioMatching : pendant la lecture de la vidéo, la technologie aligne la piste audio sur la personne qui parle. Ce processus de correspondance précise garantit que la voix et les mouvements des lèvres sont synchronisés.

- LipMovement Synchronization : Une fois la personne qui parle identifiée, la fonction de synchronisation des lèvres redessine les mouvements des lèvres pour la seule personne qui parle. Les personnes qui ne parlent pas et qui se trouvent dans le cadre ne verront pas leurs mouvements de lèvres modifiés et conserveront leur état naturel tout au long de la vidéo. Cette synchronisation s'applique exclusivement au locuteur actif, ce qui la rend efficace même en présence de voix hors champ ou de plusieurs visages dans la scène.

- Gestion desimages statiques de lèvres : il est intéressant de noter que cette technologie est également suffisamment sophistiquée pour redessiner les mouvements des lèvres sur des images statiques de lèvres si elles apparaissent dans le cadre vidéo, ce qui démontre sa capacité polyvalente.

Cette fonction de synchronisation labiale multilocuteurs améliore le réalisme et l'engagement du spectateur dans les scènes avec plusieurs locuteurs ou dans les configurations vidéo complexes, en garantissant que seules les lèvres des personnes qui parlent bougent en fonction de l'audio. Cette approche ciblée permet de maintenir l'attention sur l'orateur actif et de préserver la dynamique naturelle des interactions de groupe dans les vidéos.

À partir d'une seule vidéo, dans n'importe quelle langue, vous pouvez créer des centaines de vidéos personnalisées présentant diverses offres dans plusieurs langues. Cette polyvalence révolutionne la façon dont les spécialistes du marketing peuvent s'adresser à des publics divers et mondiaux, en améliorant l'impact et la portée du contenu promotionnel.

Comment trouver l'équilibre entre la qualité et la vitesse de traitement dans la nouvelle Lip-sync Premium ?

Dima : "L'équilibre entre une qualité élevée et une vitesse de traitement rapide dans Premium Lipsync est un défi, mais nous avons fait des progrès significatifs dans l'optimisation de l'inférence de notre modèle. Cette optimisation nous permet d'obtenir la meilleure qualité possible à une vitesse raisonnable".

Y a-t-il des imperfections intéressantes ou des surprises que vous avez rencontrées lors de la formation du modèle ?

En outre, le travail avec les occlusions autour de la bouche s'est avéré assez difficile. Ces éléments nécessitent une attention particulière aux détails et une modélisation sophistiquée pour obtenir une représentation réaliste et précise dans notre technologie de synchronisation labiale.

Comment l'équipe de la ML assure-t-elle la confidentialité et la protection des données des utilisateurs lors du traitement des documents vidéo ?

Dima : Notre équipe ML prend très au sérieux la confidentialité et la protection des données des utilisateurs. Pour le modèle Lipsync, nous n'utilisons pas les données des clients pour l'entraînement, ce qui élimine tout risque d'usurpation d'identité. Nous nous appuyons uniquement sur des données open-source accompagnées de licences appropriées pour l'entraînement de notre modèle. En outre, le modèle fonctionne comme une instance distincte pour chaque utilisateur, ce qui garantit que la vidéo finale n'est livrée qu'à l'utilisateur concerné et évite tout enchevêtrement de données.

Au fond, nous nous engageons à donner du pouvoir aux créateurs, en garantissant l'utilisation responsable de l'IA dans la création de contenu, en mettant l'accent sur les droits légaux et la transparence éthique. Nous garantissons que vos vidéos, photos, voix et ressemblances ne seront jamais utilisées sans autorisation explicite, assurant ainsi la protection de vos données personnelles et de vos actifs créatifs.

Nous sommes fiers d'être membres de The Coalition for Content Provenance and Authenticity (C2PA) et de The Content Authenticity Initiative, reflétant notre dévouement à l'intégrité et à l'authenticité du contenu à l'ère numérique. En outre, notre fondatrice et PDG, Maria Chmir, est reconnue dans le répertoire Women in AI Ethics™, soulignant notre leadership en matière de pratiques éthiques dans le domaine de l'IA.

Quelles sont les perspectives d'avenir pour le développement de la technologie de synchronisation labiale ? Y a-t-il des domaines spécifiques qui vous intéressent particulièrement ?

Dima : Nous pensons que notre technologie de synchronisation labiale peut servir de base à la poursuite du développement des avatars numériques. Nous envisageons un avenir où tout le monde pourra créer et localiser du contenu sans avoir à supporter les coûts de production vidéo.

À court terme, dans les deux prochains mois, nous nous engageons à améliorer les performances et la qualité de notre modèle. Notre objectif est d'assurer un fonctionnement fluide sur les vidéos 4K et d'améliorer la fonctionnalité des vidéos traduites dans les langues asiatiques. Ces avancées sont cruciales car nous visons à élargir l'accessibilité et la facilité d'utilisation de notre technologie, ouvrant ainsi la voie à des applications innovantes dans le domaine de la création de contenu numérique. Essayez notre fonctionnalité améliorée de synchronisation labiale et envoyez-nous vos commentaires sur cette fonctionnalité.

FAQ

La synchronisation labiale est disponible sur les plans Creator Pro, Archive Pro, Business et Enterprise.

Une minute de synchronisation labiale générée équivaut à une minute déduite de votre solde total de minutes.

Les minutes de synchronisation labiale sont déduites de la même manière que lors du doublage de vos vidéos.

La synchronisation labiale est facturée séparément du doublage. Par exemple, pour traduire et synchroniser une vidéo de 1 minute en 1 langue, vous avez besoin de 2 minutes.

Avant de générer de la synchronisation, vous pourrez tester 1 minute gratuite afin d'évaluer la qualité de la technologie.

La vitesse de génération de la synchronisation labiale dépend du nombre de locuteurs dans la vidéo, de la durée, de la qualité et de la taille de la vidéo.

À titre d'exemple, voici les taux approximatifs de génération de la synchronisation labiale pour différentes vidéos :

Vidéos avec un seul intervenant

- Vidéo de 4 minutes 1080p ≈ 29 minutes

- 10 minutes 1080p ≈ 2 heures 10 minutes

- 10 minutes de vidéo 4K ≈ 8 heures

Vidéos avec 3 intervenants :

- 10 minutes 1080p ≈ 5 heures 20 minutes

- Téléchargez votre vidéo via le lien de YouTube, Google Drive, ou téléchargez directement le fichier depuis votre appareil. Choisissez la langue cible et cliquez sur le bouton traduire.

- Ajoutez une voix off à votre vidéo sur Rask AI en cliquant sur le bouton "Dub video".

- Pour vérifier si votre vidéo est compatible avec la synchronisation labiale, cliquez sur le bouton "Vérification de la synchronisation labiale".

- Si c'est le cas, appuyez sur le bouton Lip-sync.

- Ensuite, sélectionnez le nombre de visages que vous souhaitez voir apparaître dans votre vidéo - soit "1", soit "2+", puis appuyez sur "Démarrer la synchronisation labiale". Pour information, il s'agit du nombre de visages, et non de locuteurs.

Rask%20Lens%20A%20Recap%204.webp)